借款单据对接数据库:钉钉数据集成到MySQL的技术探索

在企业信息化建设中,数据的高效流动和准确存储是实现业务智能化的重要基础。本文将聚焦于一个具体的系统对接集成案例——将钉钉平台上的借款单据数据无缝集成到MySQL数据库中。

为了确保数据从钉钉到MySQL的顺畅传输,我们采用了一系列先进的数据集成技术。首先,通过调用钉钉API v1.0/yida/processes/instances,我们能够定时可靠地抓取借款单据数据。这一过程不仅需要处理接口的分页和限流问题,还需确保每条记录都能被完整获取,不漏单。

在数据写入方面,MySQL提供了强大的execute API支持,使得大量数据能够快速批量写入数据库。这种高吞吐量的数据写入能力极大提升了整体处理效率。同时,为应对可能出现的数据格式差异,我们设计了自定义的数据转换逻辑,以适应特定业务需求。

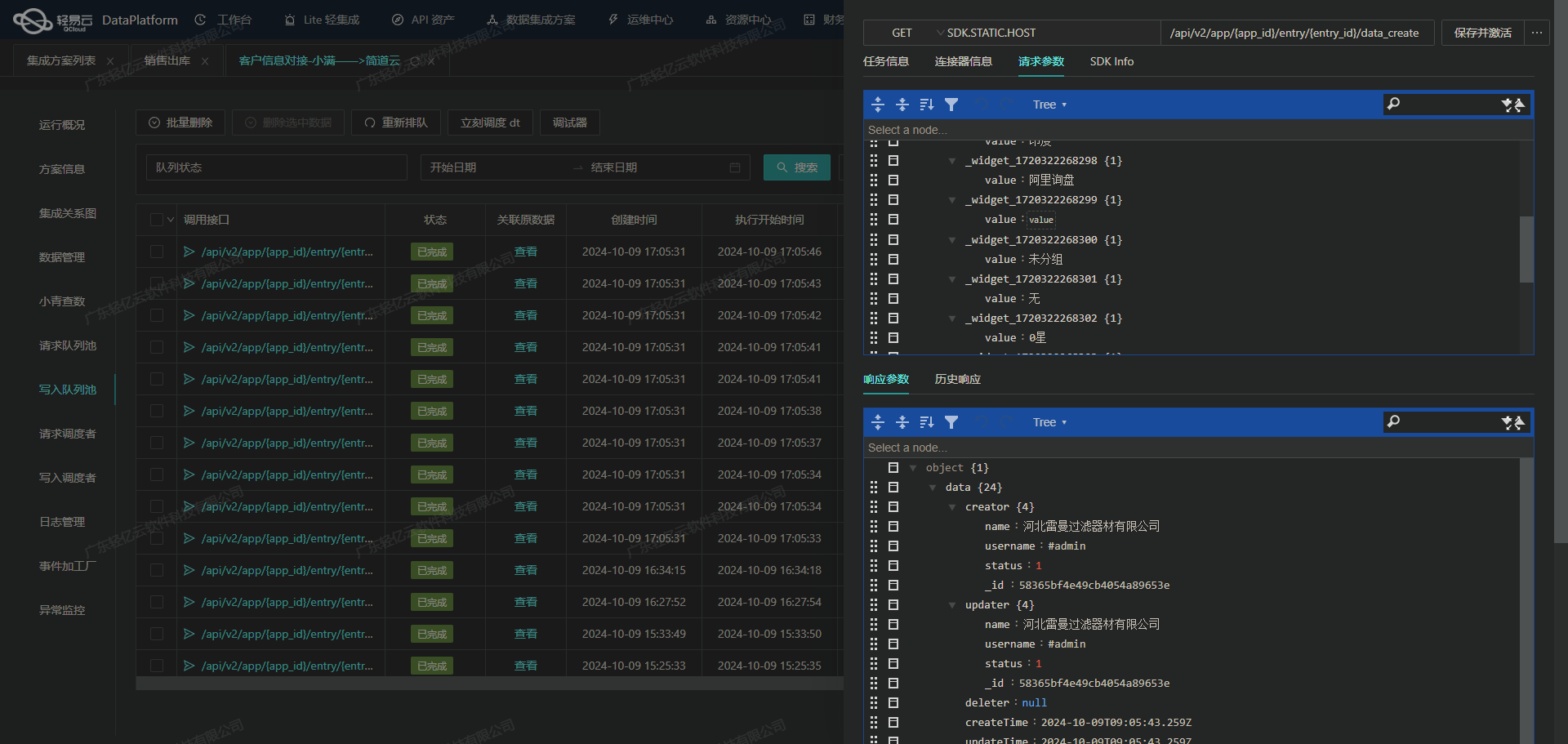

此外,整个集成过程配备了实时监控与日志记录功能,可以及时发现并处理异常情况。通过集中监控和告警系统,我们能够实时跟踪任务状态和性能,并在必要时触发错误重试机制,以确保数据对接的稳定性和可靠性。

这种全面而细致的技术方案,不仅提高了企业对API资产使用情况的掌握程度,也为资源优化配置提供了有力支持。在后续章节中,我们将深入探讨具体实施步骤及其背后的技术细节。

钉钉接口数据集成与处理技术案例

在数据集成过程中,调用钉钉接口v1.0/yida/processes/instances是实现数据请求与清洗的关键步骤。该接口允许我们从钉钉系统中获取特定的流程实例数据,并进行后续的数据加工处理。为了确保高效的数据集成,我们需要关注以下几个技术要点。

接口调用与分页处理

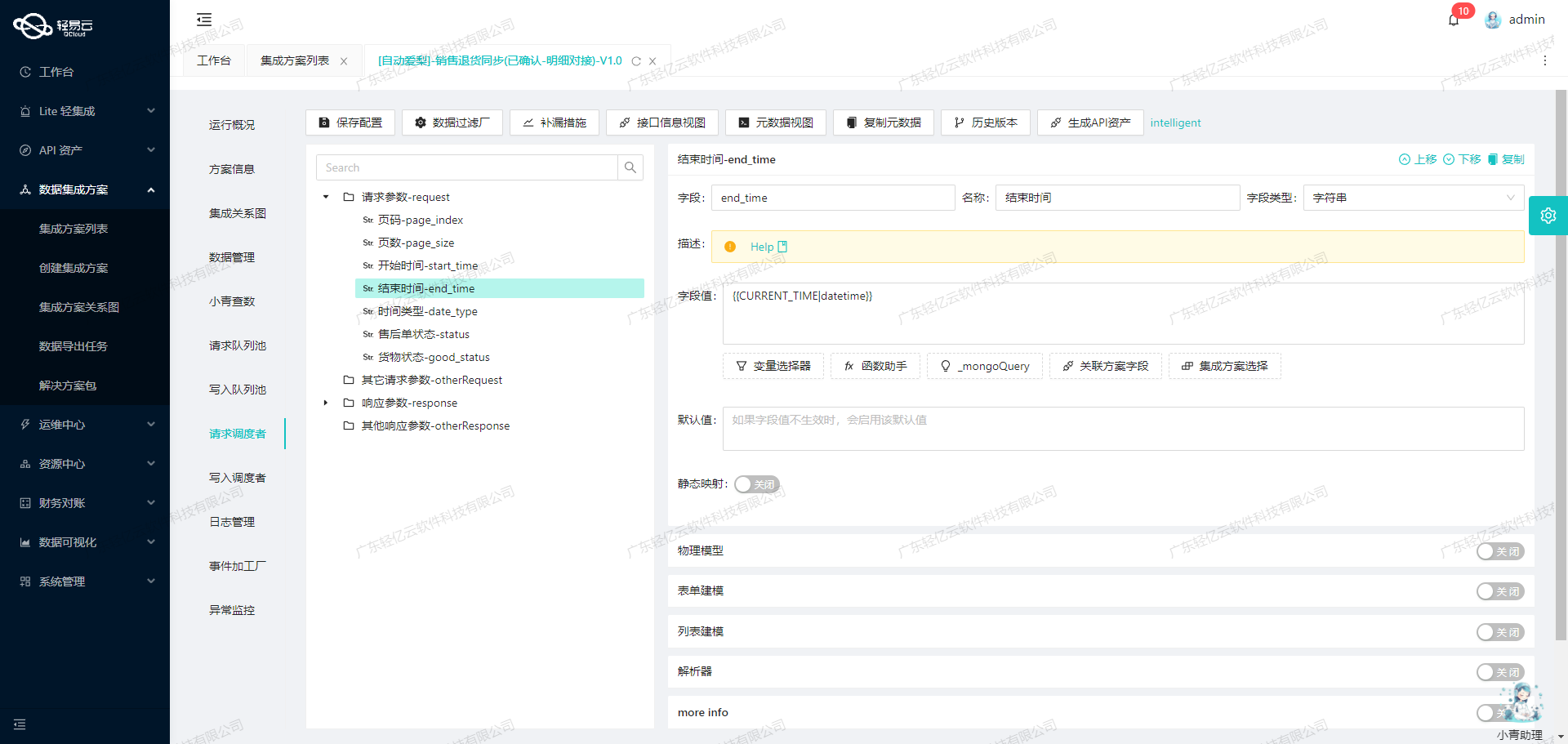

首先,接口调用采用POST方法,通过元数据配置中的参数来定义请求体。这些参数包括分页页码和分页大小,用于控制每次请求的数据量。通过设置pageNumber和pageSize,我们可以有效地管理大规模数据的抓取过程,避免因一次性请求过多数据而导致性能瓶颈。

{

"field": "pageNumber",

"value": "{PAGINATION_START_PAGE}"

},

{

"field": "pageSize",

"value": "{PAGINATION_PAGE_SIZE}"

}分页机制不仅提高了数据抓取的效率,还能帮助我们应对接口限流问题。在实际应用中,应根据业务需求动态调整分页策略,以确保稳定的数据流动。

数据过滤与条件查询

为了精准获取所需的数据,我们可以利用条件查询功能。通过设置搜索字段,如流水号、发起人工号等,可以筛选出符合特定条件的流程实例。这种灵活的查询能力使得我们能够在海量数据中快速定位目标记录,提高了数据处理的准确性。

{

"label": "条件",

"field": "searchFieldJson",

"children": [

{

"parent": "searchFieldJson",

"label": "流水号",

"field": "textField_kspgl3w6"

}

]

}时间范围与状态过滤

时间范围是另一个重要的过滤维度。通过设定创建时间和修改时间的起始值及终止值,我们可以限制返回结果在特定时间段内。这对于分析历史趋势或监控实时变化非常有用。同时,实例状态和审批结果也作为过滤条件之一,使得我们能够聚焦于已完成并同意的流程实例,从而简化后续的数据转换工作。

{

"field": "createFromTimeGMT",

"value": "_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL - 20 DAY),'%Y-%m-%d 00:00:00')"

},

{

"field": "instanceStatus",

"value": "COMPLETED"

},

{

"field": "approvedResult",

"value": "agree"

}异常处理与重试机制

在调用过程中,可能会遇到网络波动或服务器响应异常等问题。因此,实现异常处理与错误重试机制至关重要。通过监控接口调用状态并记录日志,我们可以及时发现问题并采取相应措施,如自动重试或告警通知,以保证集成任务的可靠性。

数据格式转换与写入优化

最后,在将获取到的数据写入MySQL数据库时,需要注意格式差异的问题。轻易云平台支持自定义数据转换逻辑,使得不同系统间的数据结构能够无缝对接。此外,高吞吐量写入能力确保大量数据能够快速存储到数据库中,有效提升整体处理效率。

综上所述,通过合理配置元数据、优化接口调用策略以及完善异常处理机制,我们能够高效地实现钉钉借款单据对接数据库任务,为企业提供稳定可靠的数据集成解决方案。

数据ETL转换与写入MySQLAPI的技术实现

在轻易云数据集成平台的生命周期中,第二步是对已集成的源平台数据进行ETL转换,将其转化为目标平台MySQLAPI接口能够接收的格式,并最终写入到目标数据库中。这一步骤至关重要,因为它直接影响到数据的准确性和一致性。

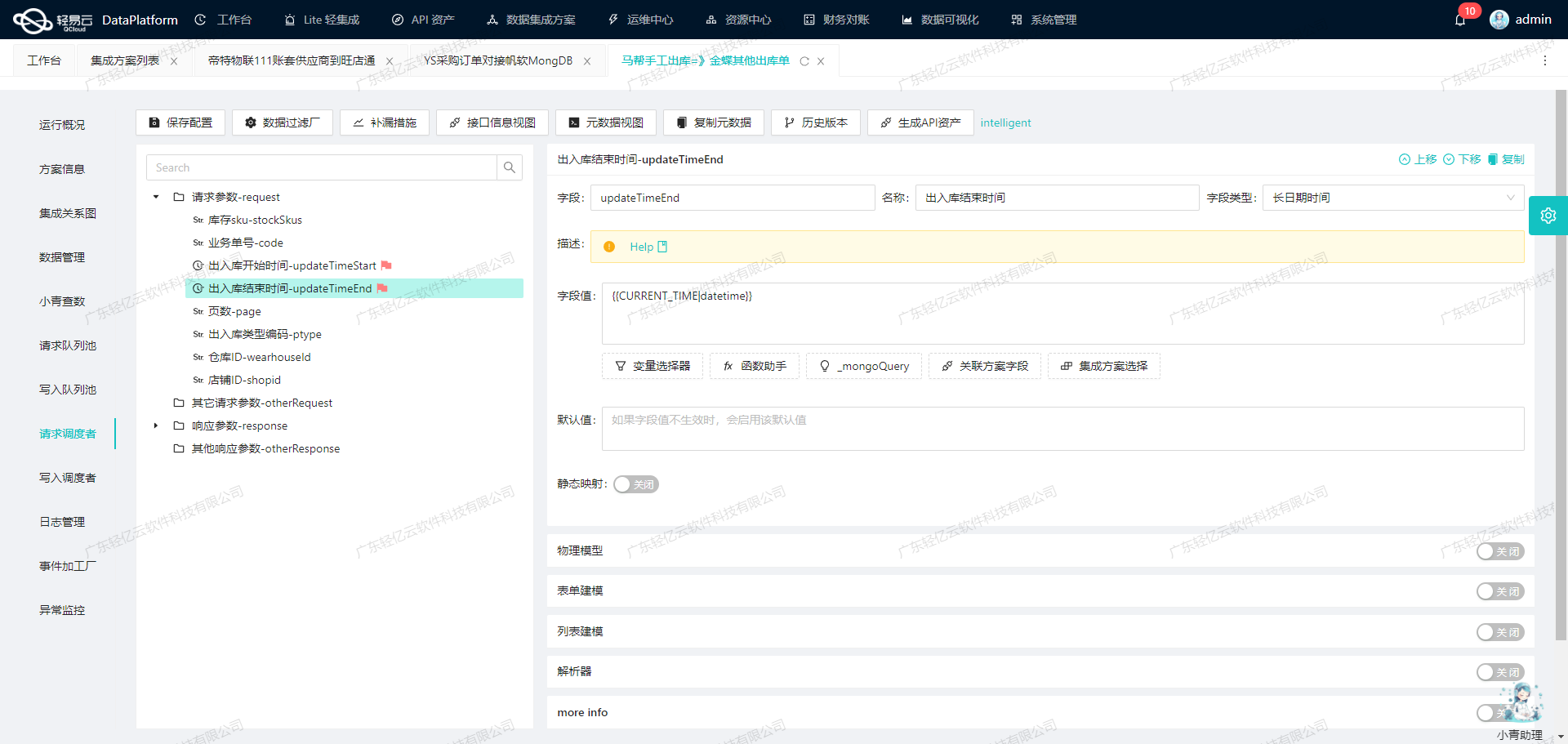

数据格式转换与映射

首先,我们需要处理钉钉接口的数据格式差异。源数据通常包含复杂的嵌套结构或特定的数据类型,为确保数据能够无缝对接到MySQL,我们必须进行细致的字段映射和类型转换。通过使用自定义的数据转换逻辑,可以解决如字符串与数值型字段之间的差异。例如,借助于元数据配置中的_function case语句,我们可以根据条件灵活地选择字段值。

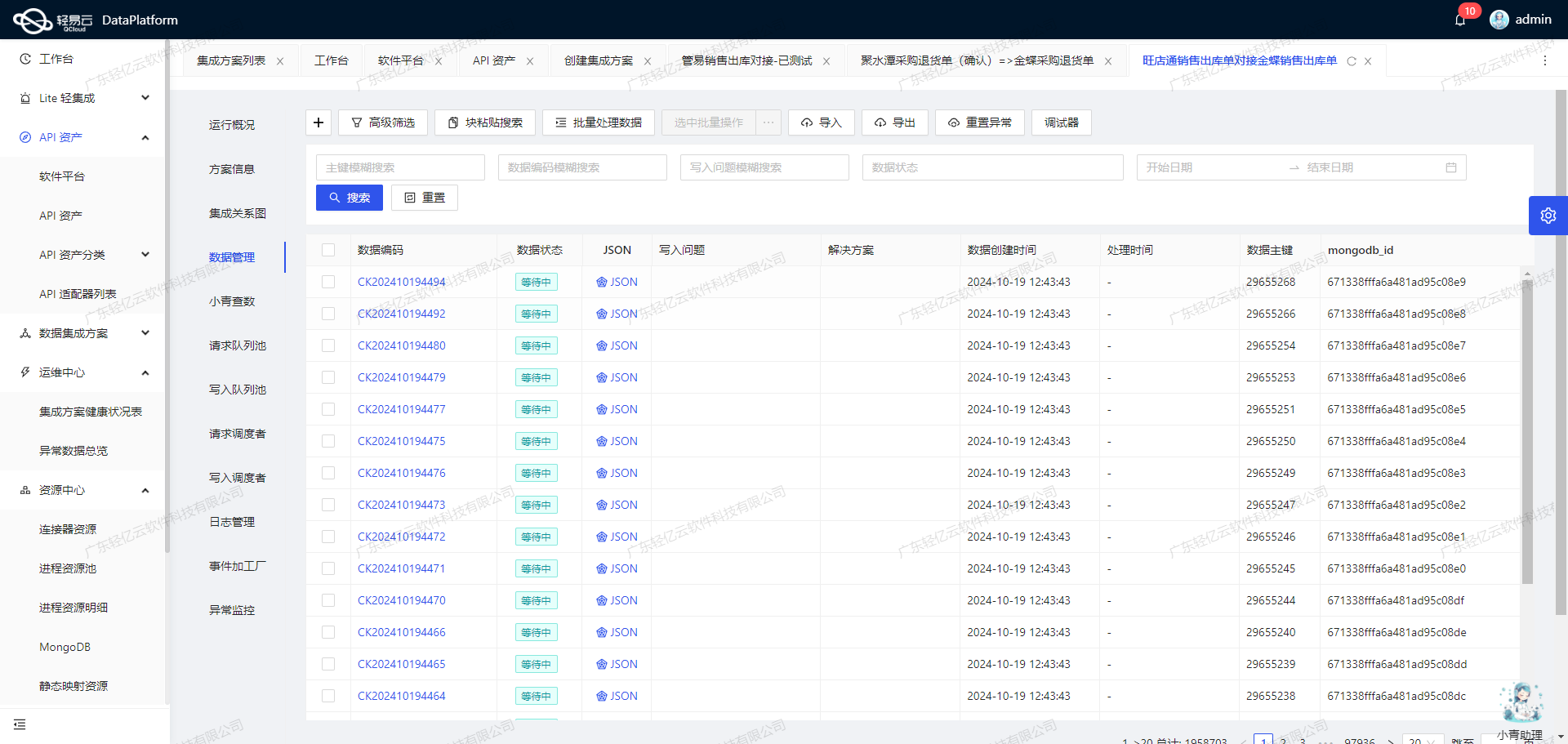

批量数据写入与高效处理

为了支持高吞吐量的数据写入能力,轻易云平台提供了批量集成的功能。通过将多个记录打包成批次写入MySQL,可以显著提高数据处理效率。这不仅减少了网络请求次数,还降低了数据库负载。在我们的案例中,主表和扩展表的插入操作分别通过main_sql、extend_sql_1和extend_sql_2实现,确保每个借款单据及其关联费用和支付信息都能完整地存储。

针对API接口的分页与限流策略

处理钉钉接口时,分页和限流问题往往是不可避免的。为此,需要在请求时设置合理的分页参数,并在响应中解析分页信息,以确保所有数据都被完整抓取。此外,通过实现限流机制,可以避免因过多请求导致接口调用失败或被封禁。这些措施对于保证集成过程中不漏单至关重要。

异常处理与重试机制

在与MySQL对接过程中,可能会遇到各种异常,如网络故障或数据库锁定等。为了提高系统的健壮性,我们设计了错误重试机制。当遇到暂时性错误时,系统会自动重试该操作,并记录相关日志以供后续分析。这种机制确保即使在不利条件下,也能最大程度上保证数据的一致性。

实时监控与日志管理

实时监控是确保数据集成过程顺利进行的重要工具。通过集中监控和告警系统,可以实时跟踪每个任务的状态和性能指标。一旦出现异常情况,系统会立即发出告警通知,以便快速响应和处理。此外,通过详细的日志记录,可以追溯每次操作,为问题排查提供依据。

自定义映射与业务逻辑适配

最后,通过可视化的数据流设计工具,我们可以直观地配置和调整数据流动路径。这使得在面对不同业务需求时,可以灵活地修改数据转换逻辑。例如,在配置元数据时,我们为每个字段设定了具体的映射规则,以适应特定业务场景下的数据结构要求。

综上所述,通过精细化的数据ETL转换、有效的数据管理策略以及完善的监控机制,轻易云平台能够高效地将源平台数据转化并写入目标MySQLAPI接口,实现稳定可靠的数据集成方案。